BetterBodies:VAE+Diffusion+RL的抗体CDRH3设计

原文链接:http://arxiv.org/abs/2409.16298

算法解析

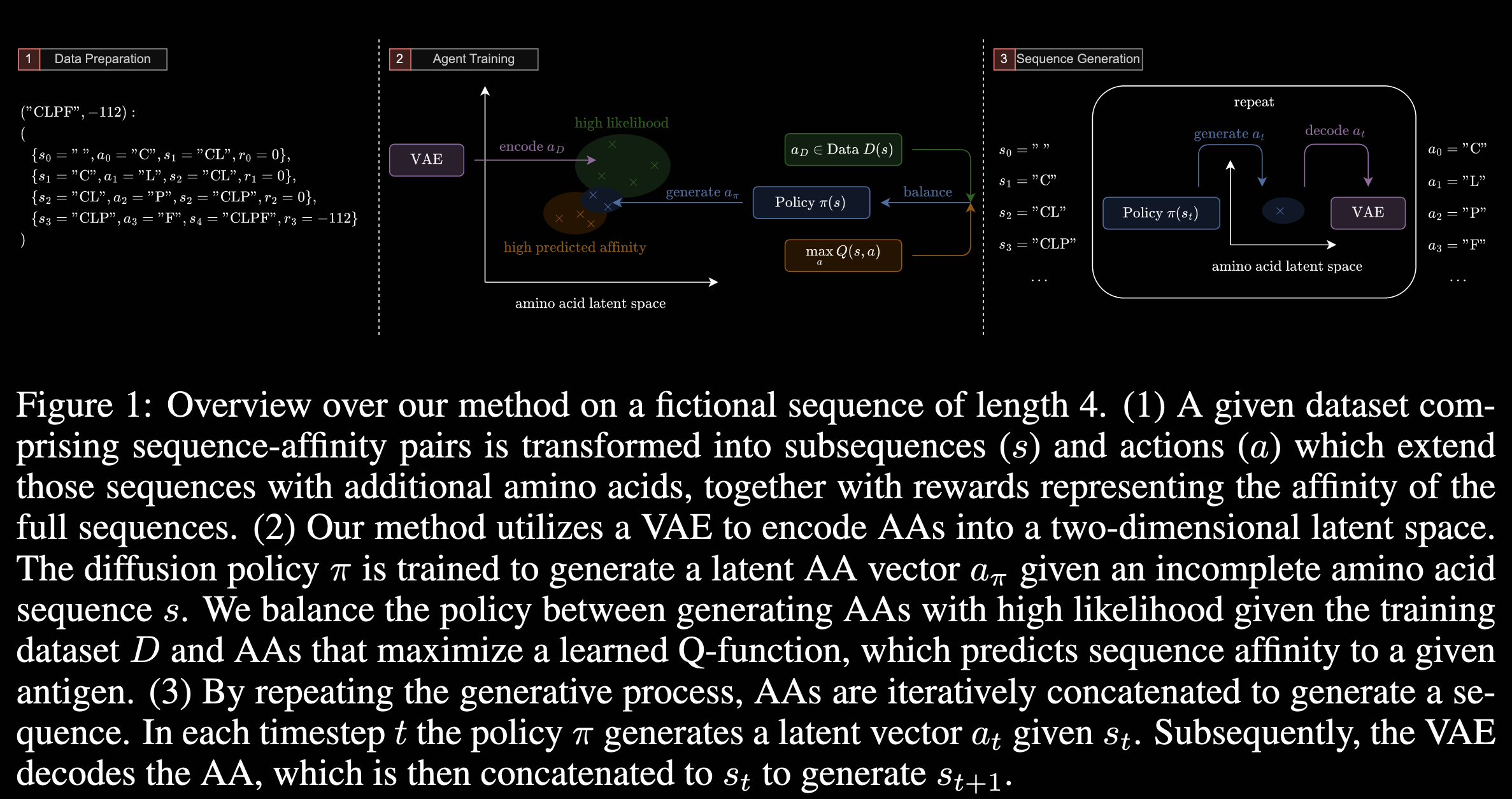

这个算法的一个设计场景是:有一组先验的HCDR3训练数据,对目标靶点亲和力较低或者没有亲和力,算法通过VAE+Diffusion构建较为大的序列隐空间,并通过RL中Q-learning生成与目标靶点具有较高的亲和力的HCDR3序列。

VAE+Diffusion

这里作者将原始序列进行VAE的encoding,然后引入了Diffusion对VAE latent space进行了扩散增强。理论上任何diffusion模型都可以应用,这里用的diffusion forward是逐渐添加高斯噪声,反向过程则是一个可学习的高斯变换。

Reinforcement Learning

这里使用了Q-Learning进行训练优化,Q-function会给Absolut!软件打分自由能较低的序列予以较高的Q-value排名

Loss定义

最终的loss由VAE+Diffusion的loss与Q value的组合:

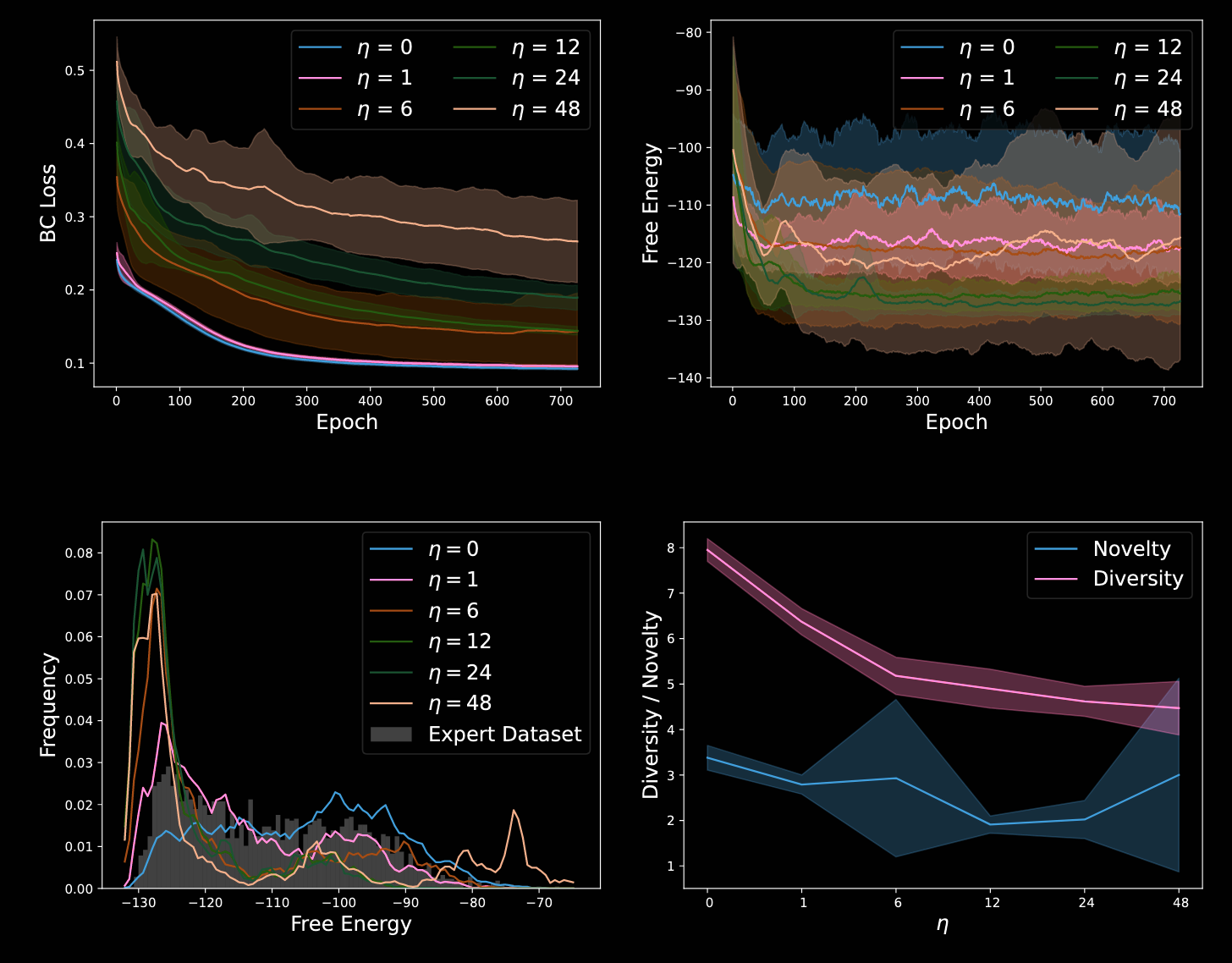

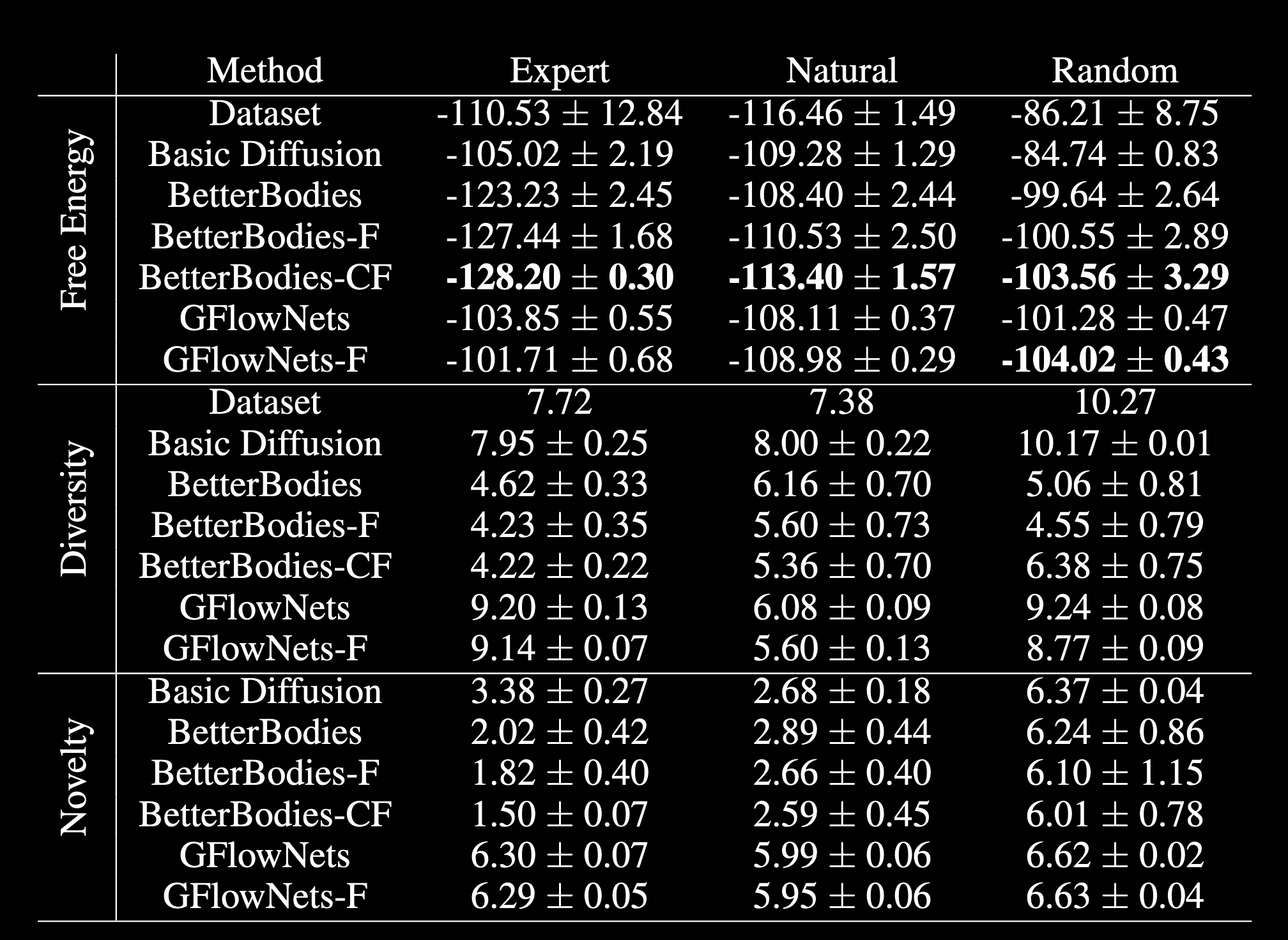

结果展示

可以看到由于加入了RL的energy优化,从计算的自由能来看确实有所提升。但是相比之下多样性显著下降。

实际上AntBO也利用了Absolut!做过基于贝叶斯优化的CDR3设计,虽然计算能量能够显著降低,但也让整个设计的序列十分不自然。本文在序列设计时也没有考虑这方面的问题。

Absolut!软件计算自由能是比较耗时的,尤其针对没有在预先计算库里的靶点。同时算法使用的栅格化计算粒度比较粗糙,因此用于CDR这里高特异性的优化其实是很难的。当然本文没有做湿实验验证,也就更无从谈起性能。

不过虽然如此,本文也给我们提供了一种将强化学习整合利用的技术思路,值得借鉴。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 潇洒记忆!